Режим Burst

В переводе с английского burst — вспышка, взрыв. В общем случае режим Burst используется для кратковременного увеличения полосы пропускания. С его помощью можно по определенным правилам превышать значение max-limit своего правила. При этом не могут быть превышены значения max-limit вышестоящего правила или pcq-rate типа очереди. С помощью настроек burst превышение скорости может быть как очень редким, так и частым.

Ранее я уже упоминал параметры очереди, которые относятся к режиму burst:

С их помощью происходит настройка активации этого режима. Я попробую своими словами рассказать, как работает Burst. Не обещаю, что получится понятно всем, но я постараюсь донести информацию. С помощью параметра burst-limit задается максимальный порог скорости при работе burst. Этот порог должен быть больше max-limit, иначе теряется его смысл. С помощью параметра burst-time задается время, в течении которого учитывается текущая средняя скорость (average-rate)

Важно. Это не время работы Burst, как я видел в некоторых описаниях в интернете

Значение average-rate рассчитывается каждую 1/16 интервала burst-time. Если у вас указано 10 секунд, средняя скорость будет рассчитываться каждую 0,625 секунды. Учтите, что на все это расходуются ресурсы процессора.

Дальше с помощью burst-threshold вы указываете порог average-rate, после превышения которого режим burst отключается. Таким образом, когда вы начинаете что-то качать, получаете максимальную скорость, указанную в burst-limit. Через некоторое время ваша средняя скорость возрастет до значения burst-threshold и режим burst будет отключен. Скорость будет равна значению max-limit. После того, как вы закончите закачку, режим burst не включится обратно сразу. Должно пройти немного времени, чтобы average-rate за интервал burst-time стал ниже burst-threshold и тогда burst включится обратно.

Рассмотрим условный пример. Это не точный расчет, я просто покажу принцип и примерные последствия, просчитанные на глазок по ходу написания статьи. Допустим, у вас указаны следующие параметры simple queue в вашем mikrotik:

- max-limit = 20M;

- burst-threshold = 15M;

- burst-time = 16s;

- burst-limit = 50M.

Вы начали качать большой файл. Первое время загрузка равна 50M (burst-limit), примерно на 5-й секунде средняя скорость за интервал в 16 (burst-time) секунд будет выше 15M (burst-threshold) (5 секунд на скорости 50M и 11 секунд 0M, пока вы еще ничего не качали, 50M*5сек + 0M*10сек)/16=15,625M, что больше 15M) и режим burst отключается. Вы продолжаете качать со скоростью 20M (max-limit), пока не загрузите весь файл. После окончания загрузки должно пройти примерно 4 секунды, чтобы у вас обратно включился burst ((20M*12сек + 0M*4сек)/16=15M). За это время у вас средняя скорость на интервале последних 16 секунд станет ниже 15M (burst-threshold). Это при условии, что вы не будете больше продолжать что-то скачивать.

Надеюсь, понятно объяснил Я в свое время очень крепко надо всем этим корпел, пока пытался разобраться. Здесь по хорошему надо график и табличку значений сделать, но мне не хочется этим заниматься. Ниже будет еще один конкретный пример, так что если не поняли, как работает burst, посмотрите его.

Настройка Simple queue в Mikrotik

Давайте потихоньку переходить к практике. Но перед этим необходимо проверить важную деталь. Для того, чтобы в Mikrotik работали очереди, необходимо обязательно отключить fasttrack. Для начала настроим равномерное распределение трафика между клиентами. Их у меня будет два:

- 192.168.88.195 — ubuntu18.

- 192.168.88.196 — centos7.

- 10.20.1.23 — сервер в «интернете», к которому будем подключаться и проверять скорость соединения.

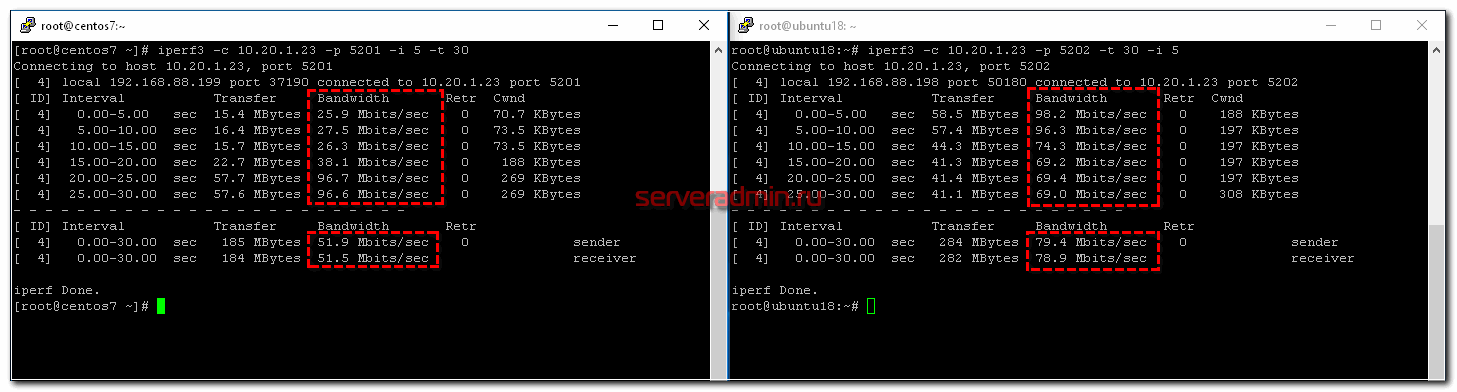

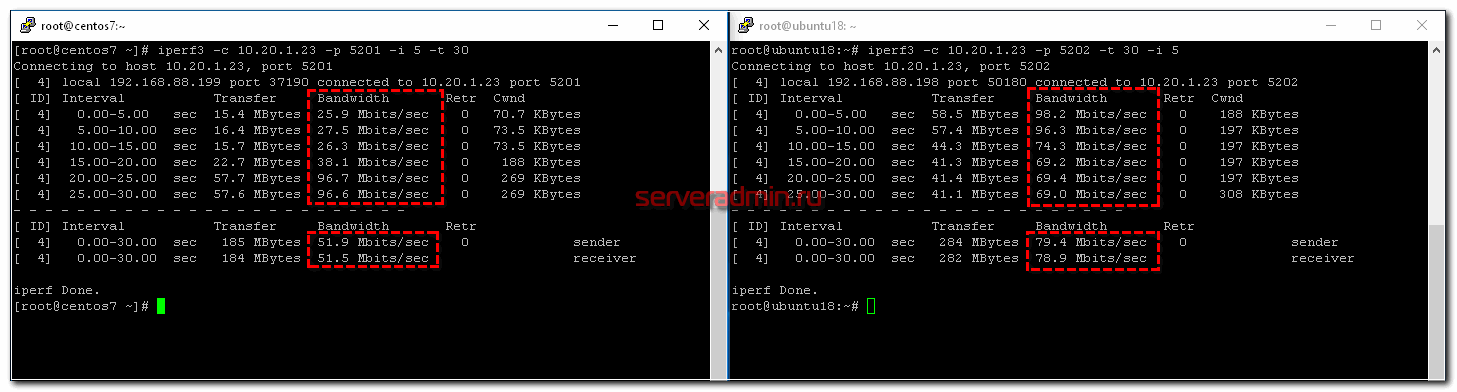

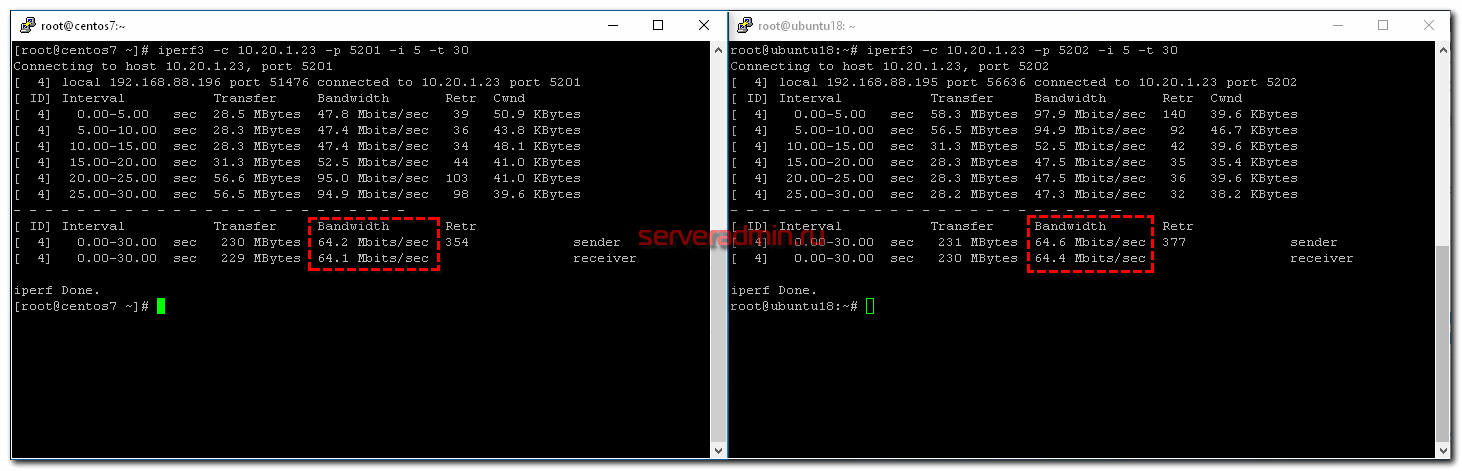

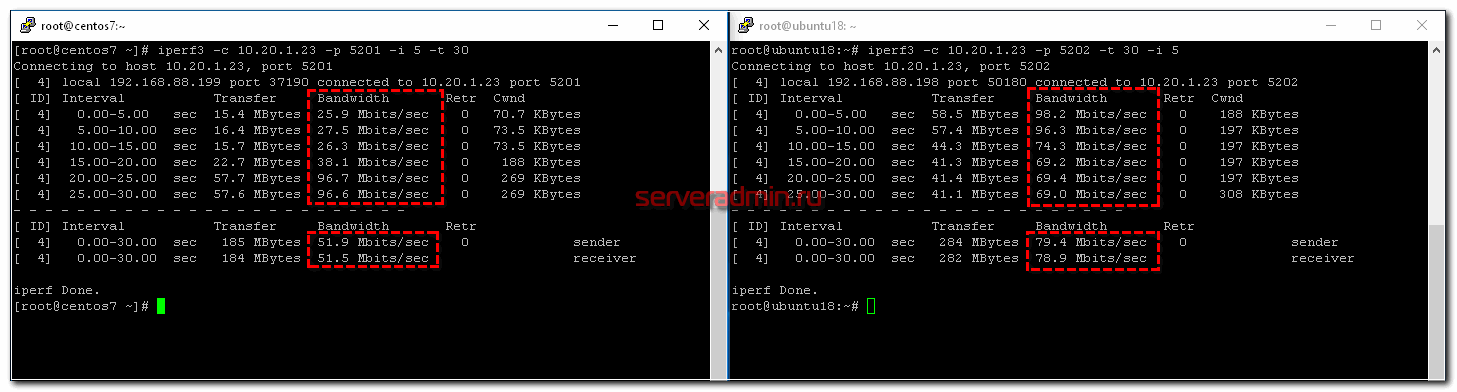

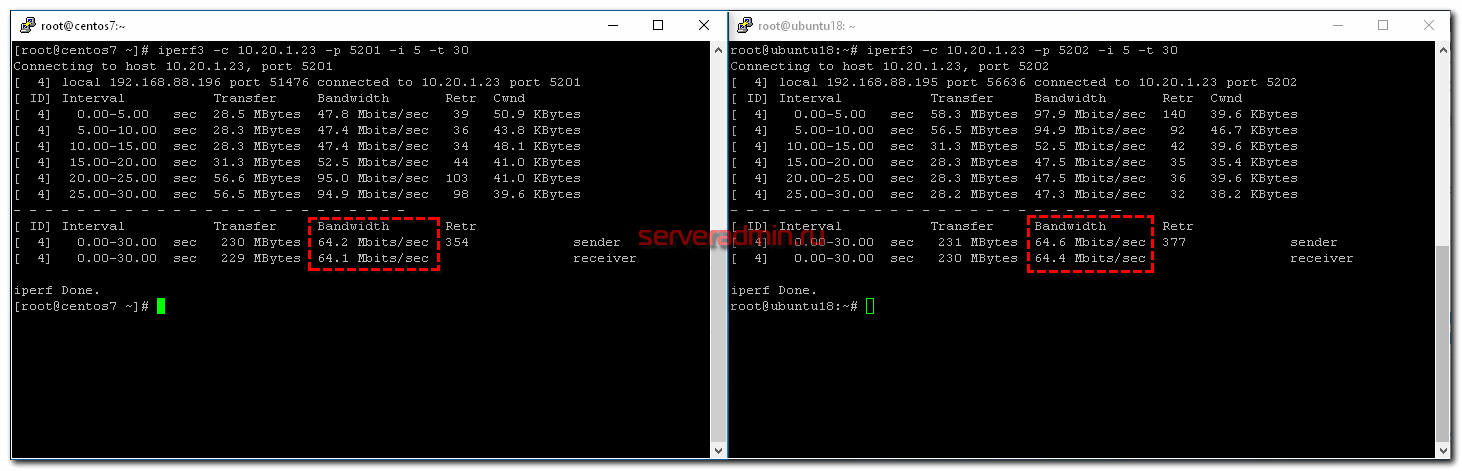

Адрес Микротика — 192.168.88.1. Измерять скорость буду с помощью программы iperf. Канал в интернет — 100 Мбит/c. Для начала посмотрим, как будет распределяться канал между клиентами без настройки qos. Для этого просто запускаю iperf на обоих клиентах с разницей в 10 секунд.

Я сначала запустил проверку скорости на ubuntu18, а через 10 секунд на centos7. Видно, что ubuntu сначала качала на полной скорости 100 Мбит/c, а потом, при запуске параллельного теста на centos, снизила скорость на треть. По факту получилось, что кто раньше запустил тест, тот и забрал себе больше канала. Средняя скорость загрузки разных клиентов отличается — 51.9 Mbits/sec у того, кто начал позже, против 79.4 Mbits/sec. Если бы тут работал какой-нибудь торрент клиент, он бы забрал большую часть канала себе.

А теперь сделаем так, чтобы скорость между клиентами распределялась равномерно. Для этого идем в очереди и создаем simple queue.

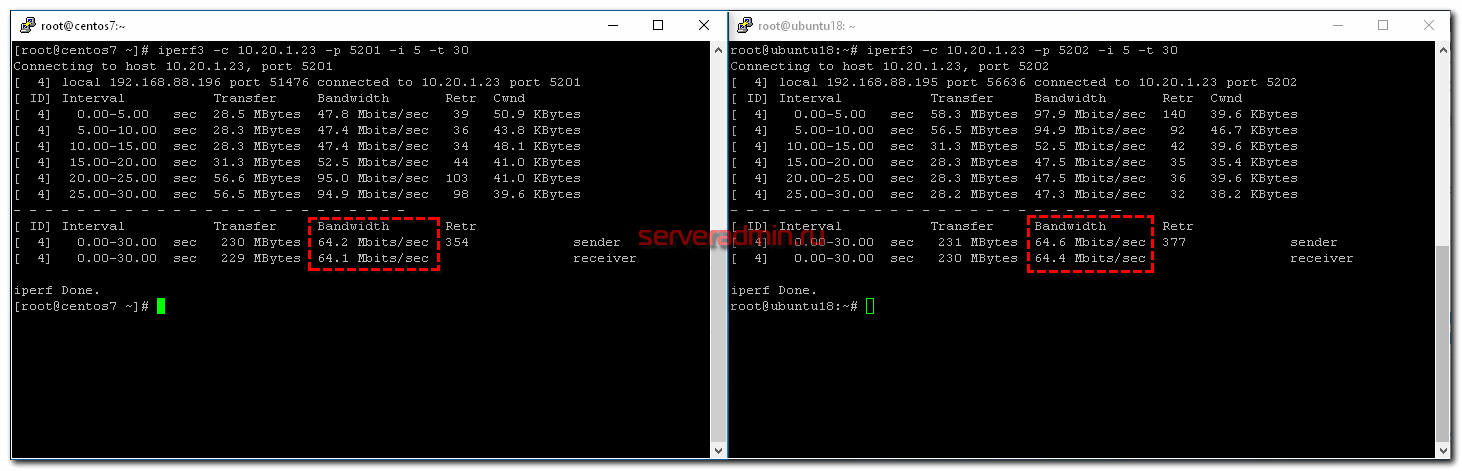

Я сделал минимально необходимые настройки. Все остальное оставил в дефолте. Это самый простой путь справедливого распределения канала между клиентами. Теперь повторим то же самое тестирование.

Работает четкое равномерное деление скорости интернет канала. В настройке Target у меня указан bridge, в который объединены все интерфейсы локальной сети. Там можно указать адрес или подсеть, например 192.168.88.0/24. Все зависит от того, что конкретно вы хотите сделать и между кем и кем поделить поровну интернет. Если у вас выход из этой локальной сети есть не только в интернет, но и в другие подсети, то укажите в Dst свой wan интерфейс, иначе скорость будет резаться всегда для всех адресов назначения.

Разберу основные параметры, которые есть в simple queue. Напомню, что все это можно посмотреть в документации.

| Target | Как я уже сказал, источник, к которому будет применено queue правило. Можно указать интерфейс или ip адрес. |

| Dst (destination) | Интерфейс или адрес, куда будет направлен поток с ограничением по queue. Обычно какой-то внешний адрес. |

| Max Limit | Максимально разрешенная скорость upload/download для данной очереди. |

| Burst Limit | Максимально разрешенная скорость upload/download для включенного режима Burst. |

| Burst Threshold | Граница средней скорости, превышение которой выключает режим burst. |

| Burst Time | Интервал времени, в течении которого выполняется оценка средней скорости передачи данных (average-rate), которая используется для управления режимом burst. |

| Packet Marks | Здесь выбираются промаркированные пакеты, если используется маркировка. |

| Limit At | Скорость, которая выделяется очереди гарантированно. |

| Priority | Приоритет для потоков данной очереди. 1 — максимальный приоритет, 8 — самый низкий. |

| Queue Type | Выбор типа очереди, перечисленной в Queue Types. |

| Parent | Очередь, являющейся родителем по отношению к текущей. |

Теперь некоторые комментарии к перечисленным параметрам.

Трафик с более высоким приоритетом будет иметь преимущество в достижении скорости, указанной в max-limit

Отсюда следствие — очень важно корректно указывать и следить за max-limit. Обычно его указывают на 5% ниже реальной скорости канала

Сумма параметров max-limit дочерних очередей может превышать лимит родительской очереди, но не может быть меньше limit-at. Приоритет работает только для дочерних очередей, не родительских. Очереди c наивысшим приоритетом будут иметь максимальный шанс на достижение указанного в них max-limit. С помощью Dst удобно управлять очередями в случае использования нескольких каналов wan. Достаточно указывать их интерфейсы в правилах очередей. Приоритизировать можно только исходящий трафик! Не все это понимают и пытаются настраивать приоритеты для входящего. Параметр limit at используется, чтобы гарантировать очереди заданную скорость, если это возможно. При этом он имеет преимущество перед приоритетом. То есть с его помощью можно гарантировать какую-то полосу пропускания трафику с низким приоритетом. Если данный канал не используется полностью, то он доступен другим очередям.

В целом, настройка simple queue в Микротике не представляет какой-то особой сложности и интуитивно понятна. Исключение только параметр Burst. Рассмотрим его отдельно.

Сторонние программы

Для владельцев Windows есть отдельные программы, уже точечно исполняющие ограничение. Вот самые популярные из них:

- Traffic Inspector

- NetLimiter

- BWMeter – сам пользовался в старые времена, когда нужно было контролировать прежде всего ВЕСЬ ТРАФИК. Но еще тогда была замечена функция ограничения скорости интернета.

- NetBalancer

- Tmeter – тоже приходилось плотно пользоваться этой программой для раздачи интернета. Т.е. во времена, когда приходилось из компьютера создавать роутер и раздавать лимитированный интернет всем подключенным.

- SoftPerfect Bandwidth Manager

- Traffic Shaper XP

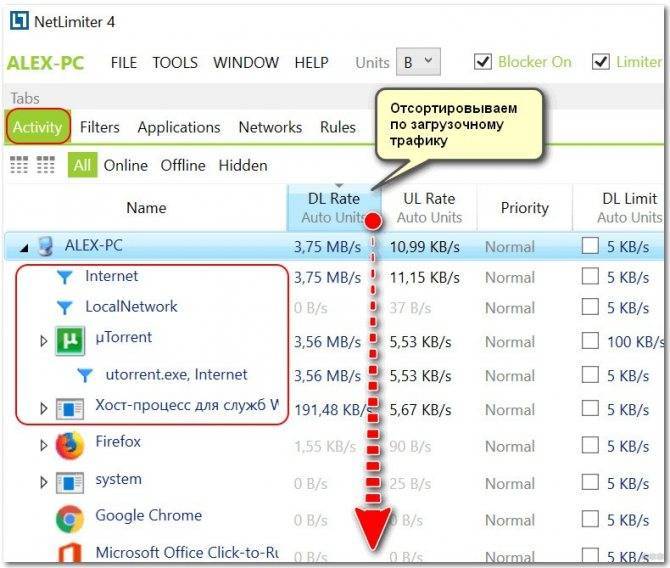

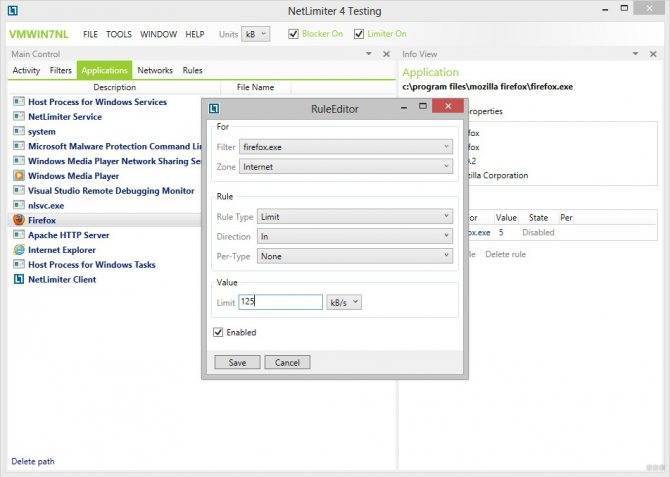

Фишка таких приложений – они могут не просто срезать весь трафик на компьютере, но и ограничить конкретное приложение. На примере NetLimiter, сортируем все программы по потреблению трафика:

А далее вносим лимит:

Приоритезация трафика на Mikrotik

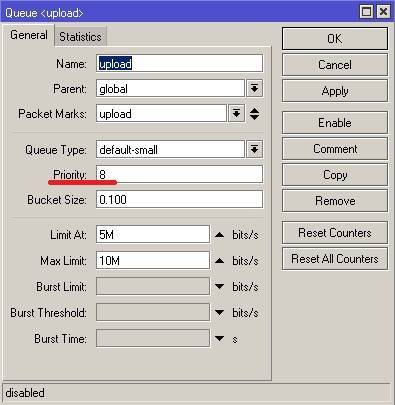

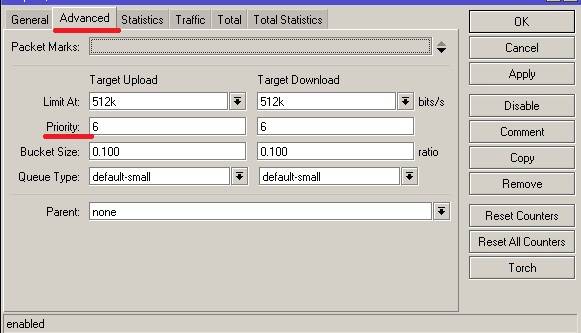

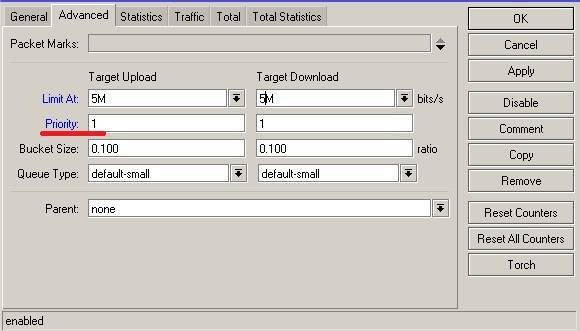

Если нужно настроить приоритизацию трафика на Mikrotik то это делается через параметр Priority в настройка Queues tree.

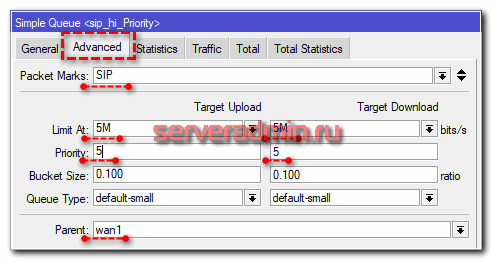

Или на вкладке Advanced в Simple Queues.

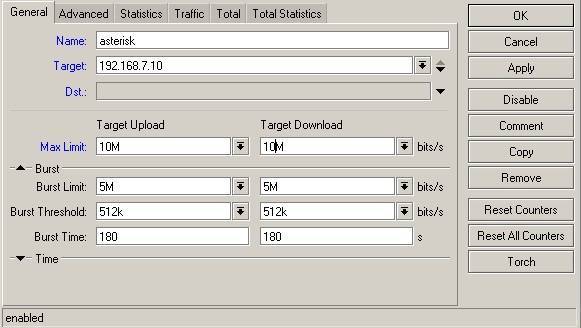

Приоритет принимает значение от 1 до 8. Чем меньше значение, тем выше приоритет, т.е очередь с priority 1 будет обрабатываться самой первой, а с 8 последней. Например если у вас есть сервер ip телефонии asterisk с ip 192.168.7.10, то для него лучше сделать настройки такие.

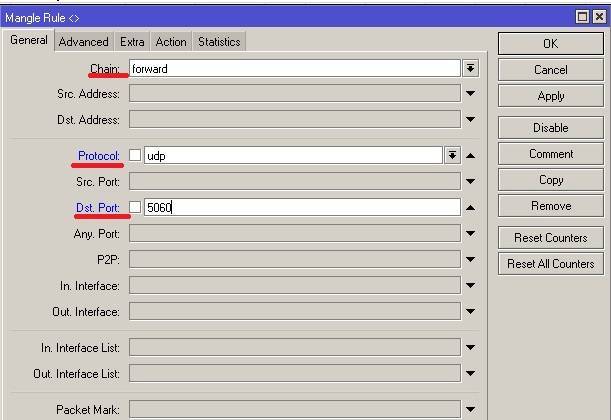

Если нам нужно настроить приоритет определенного типа трафика, например SIP, VoIP или IpTV не привязываясь к ip адресам. То сделать это можно с помощью Mangle и Queues Tree, как это сделать я писал выше, только маркируем пакеты не по ip а по протоколу и порту. Например для маркировки пакетов на порт 5060 будет выглядеть так.

Комбинируя выше указные способы можно очень гибко настроить шейпинг скорости и приоритет трафика. Также надо отметить что настройки в Queue Tree имеют больший приоритет чем в simple Queues.

Обучающий курс по настройке MikroTik

Нужно разобраться с MikroTik, но не определились с чего начать? В курсе «Настройка оборудования MikroTik» все по порядку. Подойдет и для начала работы с этим оборудованием, и для того, чтобы систематизировать знания. Это видеокурс из 162 уроков и 45 лабораторных работ, построен на официальной программе MTCNA. Проходить можно, когда удобно и пересматривать по необходимости – материалы курса выдаются бессрочно. Также есть 30 дней на личные консультации с автором. На пробу выдают 25 уроков бесплатно, заказать их можно на .

Ограничение скорости на интерфейсе

В заключении статьи про qos в mikrotik рассмотрим пример с ограничением скорости на конкретном интерфейсе. Если у вас все получилось с очередями ранее, думаю, проблем с лимитированием скорости интерфейса не возникнет. Для этого достаточно создать отдельную очередь в simple queue, у которой в параметре Target указать нужный интерфейс. Причем это может быть как физический интерфейс, так и бридж, либо какое-то виртуальное соединение (pptp, l2tp и т.д.).

Итак, включаем ограничение скорости физического интерфейса микротика. Идем в Queues и добавляем правило.

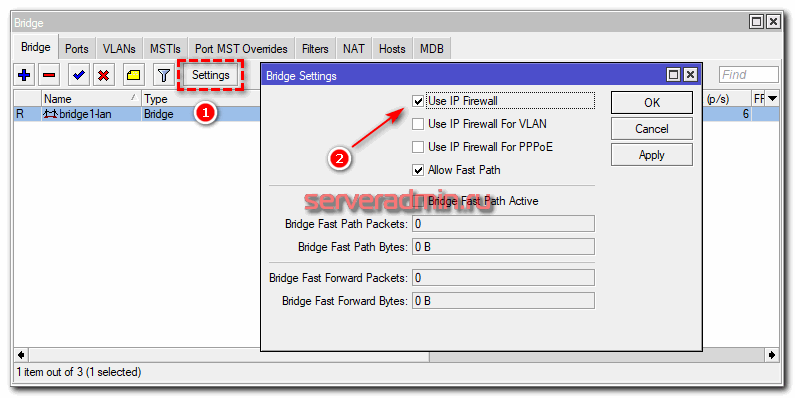

Важно понимать один нюанс. Если у вас порт находится в bridge, то данное ограничение работать не будет

Необходимо в качестве Target указывать весь бридж. Если же вам это не подходит и хочется ограничить скорость интерфейса в бридже, но не убирать его оттуда, то надо маркировать пакеты. Для этого в Mangle надо делать маркировку по признаку In / Out Bridge Port. Чтобы она заработала, в свойствах бриджа необходимо включить Use Ip Firewall.

Ну и дальше в queue указывать маркировку пакетов из бриджа, как мы уже делали ранее. Я на практике это не проверял, так как не смог смоделировать на своем тестовом стенде. У меня все абоненты подключены к одному сетевому интерфейсу микротика.

Настройка Simple queue в Mikrotik

Давайте потихоньку переходить к практике. Но перед этим необходимо проверить важную деталь. Для того, чтобы в Mikrotik работали очереди, необходимо обязательно отключить . Для начала настроим равномерное распределение трафика между клиентами. Их у меня будет два:

- 192.168.88.195 – ubuntu18.

- 192.168.88.196 – centos7.

- 10.20.1.23 – сервер в “интернете”, к которому будем подключаться и проверять скорость соединения.

Адрес Микротика – 192.168.88.1. Измерять скорость буду с помощью программы iperf. Канал в интернет – 100 Мбит/c. Для начала посмотрим, как будет распределяться канал между клиентами без настройки qos. Для этого просто запускаю iperf на обоих клиентах с разницей в 10 секунд.

Я сначала запустил проверку скорости на ubuntu18, а через 10 секунд на centos7. Видно, что ubuntu сначала качала на полной скорости 100 Мбит/c, а потом, при запуске параллельного теста на centos, снизила скорость на треть. По факту получилось, что кто раньше запустил тест, тот и забрал себе больше канала. Средняя скорость загрузки разных клиентов отличается – 51.9 Mbits/sec у того, кто начал позже, против 79.4 Mbits/sec. Если бы тут работал какой-нибудь торрент клиент, он бы забрал большую часть канала себе.

А теперь сделаем так, чтобы скорость между клиентами распределялась равномерно. Для этого идем в очереди и создаем simple queue.

Я сделал минимально необходимые настройки. Все остальное оставил в дефолте. Это самый простой путь справедливого распределения канала между клиентами. Теперь повторим то же самое тестирование.

Работает четкое равномерное деление скорости интернет канала. В настройке Target у меня указан bridge, в который объединены все интерфейсы локальной сети. Там можно указать адрес или подсеть, например 192.168.88.0/24. Все зависит от того, что конкретно вы хотите сделать и между кем и кем поделить поровну интернет. Если у вас выход из этой локальной сети есть не только в интернет, но и в другие подсети, то укажите в Dst свой wan интерфейс, иначе скорость будет резаться всегда для всех адресов назначения.

Разберу основные параметры, которые есть в simple queue. Напомню, что все это можно посмотреть в .

| Target | Как я уже сказал, источник, к которому будет применено queue правило. Можно указать интерфейс или ip адрес. |

| Dst (destination) | Интерфейс или адрес, куда будет направлен поток с ограничением по queue. Обычно какой-то внешний адрес. |

| Max Limit | Максимально разрешенная скорость upload/download для данной очереди. |

| Burst Limit | Максимально разрешенная скорость upload/download для включенного режима Burst. |

| Burst Threshold | Граница средней скорости, превышение которой выключает режим burst. |

| Burst Time | Интервал времени, в течении которого выполняется оценка средней скорости передачи данных (average-rate), которая используется для управления режимом burst. |

| Packet Marks | Здесь выбираются промаркированные пакеты, если используется маркировка. |

| Limit At | Скорость, которая выделяется очереди гарантированно. |

| Priority | Приоритет для потоков данной очереди. 1 – максимальный приоритет, 8 – самый низкий. |

| Queue Type | Выбор типа очереди, перечисленной в Queue Types. |

| Parent | Очередь, являющейся родителем по отношению к текущей. |

Теперь некоторые комментарии к перечисленным параметрам.

Трафик с более высоким приоритетом будет иметь преимущество в достижении скорости, указанной в max-limit

Отсюда следствие – очень важно корректно указывать и следить за max-limit. Обычно его указывают на 5% ниже реальной скорости канала

Сумма параметров max-limit дочерних очередей может превышать лимит родительской очереди, но не может быть меньше limit-at. Приоритет работает только для дочерних очередей, не родительских. Очереди c наивысшим приоритетом будут иметь максимальный шанс на достижение указанного в них max-limit.

С помощью Dst удобно управлять очередями в случае использования нескольких каналов wan. Достаточно указывать их интерфейсы в правилах очередей.

Приоритизировать можно только исходящий трафик! Не все это понимают и пытаются настраивать приоритеты для входящего.

Параметр limit at используется, чтобы гарантировать очереди заданную скорость, если это возможно. При этом он имеет преимущество перед приоритетом. То есть с его помощью можно гарантировать какую-то полосу пропускания трафику с низким приоритетом. Если данный канал не используется полностью, то он доступен другим очередям.

В целом, настройка simple queue в Микротике не представляет какой-то особой сложности и интуитивно понятна. Исключение только параметр Burst. Рассмотрим его отдельно.

Немного про ограничитель скорости(bandwidth control) Queues в MikroTik

В маршрутизаторах(роутерах) MikroTik чаще всего используют два самых распространённых метода по ограничиванию скорости для локальных подключений:

- С резервированием канала. Имеет популярность в QOS трафике – звук и видео, тем самым не позволяет создавать прерывания при загрузке общего канала.

- Равномерное распределение ширины канала на всех участников. Продуктивный способ использования интернет канала на всю ширину.

И масса других вариантов, когда можно комбинировать оба способа в разной последовательности. В рамках данной статьи рассмотрим п.2, как более часто встречаемое в частном и корпоративном сегменте.

Приоритет SIP трафика для VOIP

Настроить приоритет SIP трафика можно как минимум двумя принципиально разными способами:

- Самый простой случай, когда вам нужно настроить приоритет SIP трафика с вашего сервера VOIP в интернет. Для этого можно воспользоваться предыдущим примером с настройкой приоритета по ip, явно создав правило с высоким приоритетом для ip адреса сервера телефонии. Этого будет достаточно, если у вас в сети свой сервер, а все клиенты звонят через него.

- Если же у вас в сети много sip клиентов, которые напрямую подключаются к voip серверу через интернет и выделить их в отдельную подсеть не представляется возможным, то придется действовать по-другому. Нужно маркировать весь sip трафик и отдавать приоритет на основе этой маркировки. Такой случай разобран выше на примере http трафика.

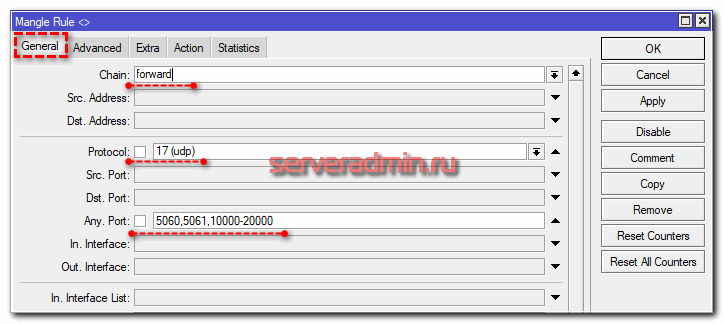

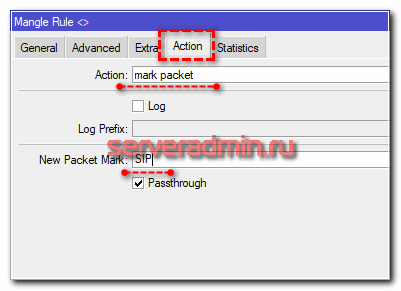

Так что в зависимости от своей ситуации, подбирайте реализацию приоритета конкретно под ваш случай. Я покажу пример второго способа с маркировкой. Снова идем в IP -> Firewall -> Mangle и добавляем правило маркировки для sip трафика.

add action=mark-packet chain=forward comment=SIP new-packet-mark=SIP passthrough=yes port=5060,5061,10000-20000 protocol=udp

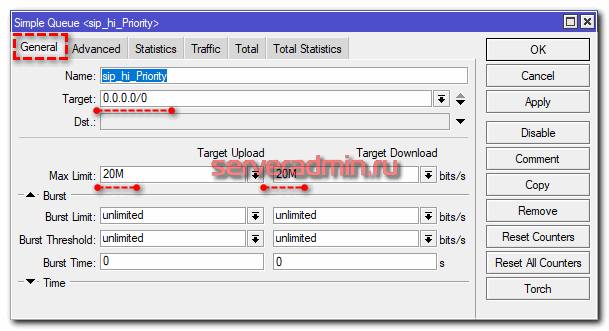

И как обычно, добавляем еще одну simple queue с более высоким приоритетом промаркированного sip трафика.

Думаю, что для sip трафика burst не нужен. Я не могу себе представить ситуацию, когда возможен какой-то резкий скачек трафика у отдельно взятого абонента. Не забывайте про порядок правил очередей. С более высоким приоритетом правила ставим выше.

На практике показать работу приоритета для sip трафика затруднительно. Я не знаю, как практически это сделать. В итоге проверил так. Взял утилиту sipp, которая есть для linux. Далее запустил ее и нагенерировал sip трафик. Убедился, что он попал в правила маркировки, а так же в указанную очередь. Если счетчики пакетов там растут, значит все сделали правильно и приоритезация будет работать. Ведь работу самих очередей мы уже проверили ранее.

Как включить qos

Существует довольно много различных моделей, они делятся на категории в зависимости от области применения. Речь идёт о применении в условиях дома, также офиса или же более масштабных проектах.

Некоторые устройства могут назначать только лишь первоочерёдность использования между устройствами, а другие позволяют выделять типы трафика и другое. Сложно конкретно рассказать об особенностях настройки каждого, но вполне можно выделить главные этапы, которые помогут наладить работу QoS с целью достижения наилучшего качества и скорости работы в интернет.

Настройка

Определяем цель.

- Контроль трафика.

- Наладка требуемого стабильного распределения.

- Гарантия качества, а также распределение скорости доступа к сети для отдельных клиентов.

- Предупреждение возможности возникновения сетевых перезагрузок.

- Снижение расходов на Uplink.

Несмотря на такое различие в целях, принцип настройки очень похож между собой.

Определение скорости интернета. Для оператора связи этот параметр является конкретным и в последующем делится большим количеством пользователей в соотношении с их тарифными планами. Именно данную задачу и позволяет решить QoS. А вот скорость домашнего интернета не всегда совпадает с той которую обещает провайдер

На то могут быть различные причины и поэтому важно уметь определить реальный показатель перед тем, как приступать к настройке QoS. Для этого вам необходимо будет остановить работу всех программ на вашем ПК

Далее используйте специальные приложения для прохождения подобного теста.

Сложно привести алгоритм включения, так как у каждого производителя и на моделях он может отличаться. В большинстве случаев вам необходимо будет перейти на страницу, где осуществляется настройка, для этого введите в поисковике его адрес. Далее введите логин и пароль которые у вас указаны в инструкции. Перейдите в раздел NAT сетевых настроек, и соответственно вкладку QoS. Теперь укажите требуемые вам параметры.

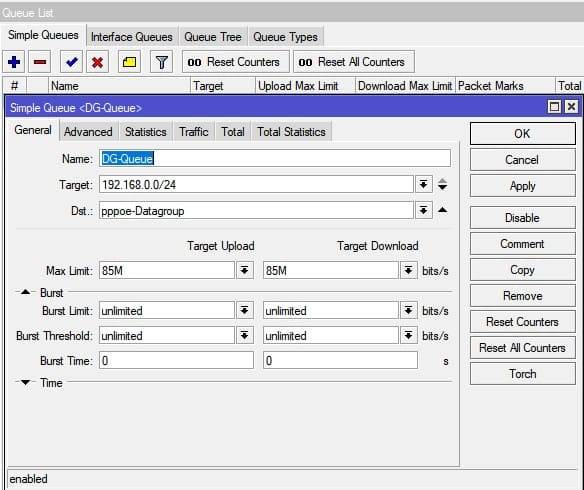

Как настроить MikroTik Simple Queues

Настройка находится в Queues->Simple Queues

/queue simple add dst=pppoe-Datagroup max-limit=85M/85M name=DG-Queue priority=1/1 queue= pcq-upload-default/pcq-download-default target=192.168.0.0/24 total-queue=default

Как будет распределяться трафик?

Общий исходящий канал 100Мб будет делиться между всеми клиентами равномерно. Когда подключается первый клиент, ему отдается вся ширина канала, а при подключении второго – ширина канала делится между двумя клиентами. Но это правило уходит ещё глубже: если первый клиент потребляет 5% трафика, а второму нужно 80% – оба запроса будут удовлетворены. Но как только запросы обоих клиентов превышают 50% пропускной способности канала, срабатывает ограничитель равномерного распределения.

Max Limit – максимальная ширина канала. Значение должно быть меньше скорости, предоставляемой провайдером, иначе шейпер не сработает и возложиться на провайдера.

В данном примере значение 85Мб было подобрано опытным путём из-за большого количества клиентов и потребляемого трафика.

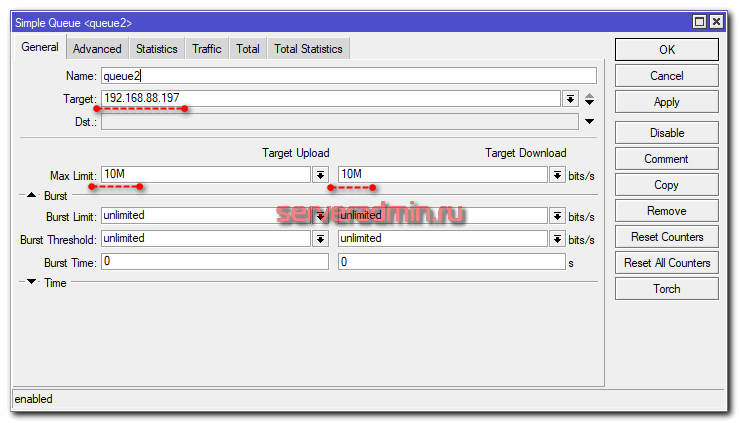

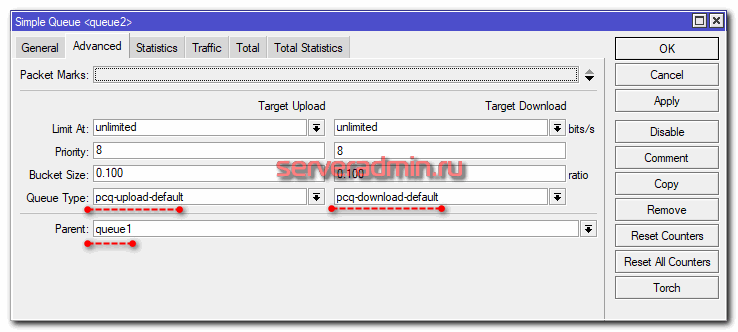

Ограничение скорости по IP

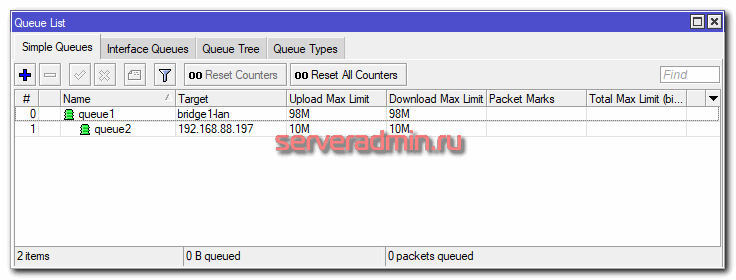

Продолжим изучать функционал qos в mikrotik на основе simple queue. Добавим к нашей предыдущей настройке ограничение максимальной скорости доступа в интернет для конкретного ip. Для этого создаем зависимую queue для ip 192.168.88.197 со следующими параметрами.

Должно получиться вот так, если отсортировать список по #.

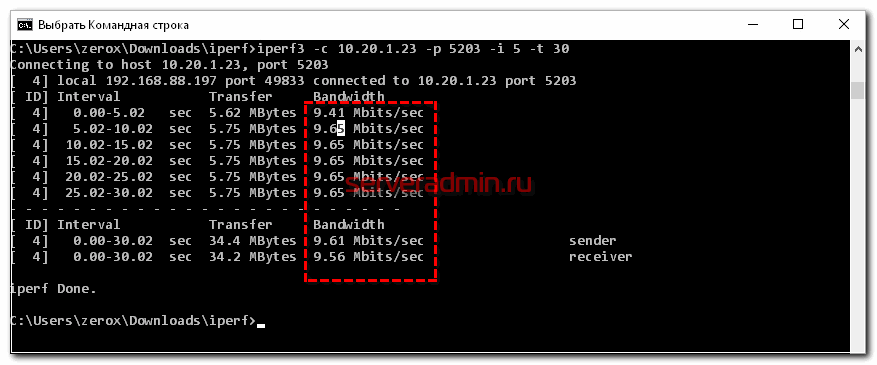

Проверяем скорость доступа в интернет с помощью iperf.

Как мы видим, ограничение скорости по ip работает. При этом скорость режется сразу, так как режим burst не настроен и не активирован. Теперь добавим к этому правилу настройку Burst и посмотрим, как она в реальности будет влиять на полосу пропускания. Для этого добавляем несколько параметров Burst. Я специально указал достаточно низкий burst-time, чтобы наглядно было видно результат работы burst.

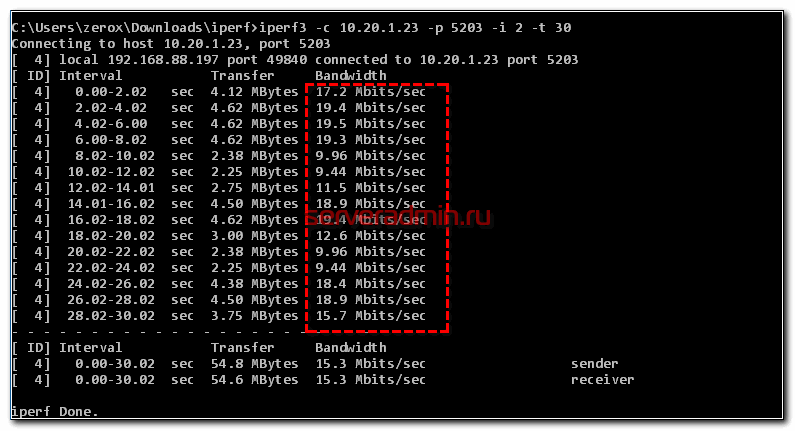

Смотрим, что получилось.

Загрузка начинается на максимальной скорости. Потом отключается burst и скорость падает до max-limit. Через некоторое время падает average-rate и burst включается снова. И так несколько раз в течении всей загрузки канала.

Микротик ограничение скорости. Настройка приоритета трафика (QoS) — ИТ Проффи

В статье подробно описано, как настроить на Микротике ограничение скорости по отдельному ip или на целую сеть, ограничение на интерфейсе и физическом порту. А также настройка приоритета трафика (QoS), для sip, tv и других сервисов. Все настройки будут производиться через программу winbox.

Если у Вас версия RouterOS выше 6.29, то перед настройкой шейпера убедитесь. что в firewall отключен fasttrack, эта технология позволяет увеличить производительность маршрутизатора, но если она включена, то шейпить скорость не получится. Заходим в меню

на вкладке Filter Rules

, ищем правило fasttrack connection.

Если такое правило существует, то отключаем или удаляем его.

Настройка Simple queue в Mikrotik

Давайте потихоньку переходить к практике. Но перед этим необходимо проверить важную деталь. Для того, чтобы в Mikrotik работали очереди, необходимо обязательно отключить fasttrack. Для начала настроим равномерное распределение трафика между клиентами. Их у меня будет два:

- 192.168.88.195 — ubuntu18.

- 192.168.88.196 — centos7.

- 10.20.1.23 — сервер в «интернете», к которому будем подключаться и проверять скорость соединения.

Адрес Микротика — 192.168.88.1. Измерять скорость буду с помощью программы iperf. Канал в интернет — 100 Мбит/c. Для начала посмотрим, как будет распределяться канал между клиентами без настройки qos. Для этого просто запускаю iperf на обоих клиентах с разницей в 10 секунд.

Я сначала запустил проверку скорости на ubuntu18, а через 10 секунд на centos7. Видно, что ubuntu сначала качала на полной скорости 100 Мбит/c, а потом, при запуске параллельного теста на centos, снизила скорость на треть. По факту получилось, что кто раньше запустил тест, тот и забрал себе больше канала. Средняя скорость загрузки разных клиентов отличается — 51.9 Mbits/sec у того, кто начал позже, против 79.4 Mbits/sec. Если бы тут работал какой-нибудь торрент клиент, он бы забрал большую часть канала себе.

А теперь сделаем так, чтобы скорость между клиентами распределялась равномерно. Для этого идем в очереди и создаем simple queue.

Я сделал минимально необходимые настройки. Все остальное оставил в дефолте. Это самый простой путь справедливого распределения канала между клиентами. Теперь повторим то же самое тестирование.

Работает четкое равномерное деление скорости интернет канала. В настройке Target у меня указан bridge, в который объединены все интерфейсы локальной сети. Там можно указать адрес или подсеть, например 192.168.88.0/24. Все зависит от того, что конкретно вы хотите сделать и между кем и кем поделить поровну интернет. Если у вас выход из этой локальной сети есть не только в интернет, но и в другие подсети, то укажите в Dst свой wan интерфейс, иначе скорость будет резаться всегда для всех адресов назначения.

Разберу основные параметры, которые есть в simple queue. Напомню, что все это можно посмотреть в документации.

| Target | Как я уже сказал, источник, к которому будет применено queue правило. Можно указать интерфейс или ip адрес. |

| Dst (destination) | Интерфейс или адрес, куда будет направлен поток с ограничением по queue. Обычно какой-то внешний адрес. |

| Max Limit | Максимально разрешенная скорость upload/download для данной очереди. |

| Burst Limit | Максимально разрешенная скорость upload/download для включенного режима Burst. |

| Burst Threshold | Граница средней скорости, превышение которой выключает режим burst. |

| Burst Time | Интервал времени, в течении которого выполняется оценка средней скорости передачи данных (average-rate), которая используется для управления режимом burst. |

| Packet Marks | Здесь выбираются промаркированные пакеты, если используется маркировка. |

| Limit At | Скорость, которая выделяется очереди гарантированно. |

| Priority | Приоритет для потоков данной очереди. 1 — максимальный приоритет, 8 — самый низкий. |

| Queue Type | Выбор типа очереди, перечисленной в Queue Types. |

| Parent | Очередь, являющейся родителем по отношению к текущей. |

Теперь некоторые комментарии к перечисленным параметрам.

Трафик с более высоким приоритетом будет иметь преимущество в достижении скорости, указанной в max-limit

Отсюда следствие — очень важно корректно указывать и следить за max-limit. Обычно его указывают на 5% ниже реальной скорости канала

Сумма параметров max-limit дочерних очередей может превышать лимит родительской очереди, но не может быть меньше limit-at. Приоритет работает только для дочерних очередей, не родительских. Очереди c наивысшим приоритетом будут иметь максимальный шанс на достижение указанного в них max-limit. С помощью Dst удобно управлять очередями в случае использования нескольких каналов wan. Достаточно указывать их интерфейсы в правилах очередей. Приоритизировать можно только исходящий трафик! Не все это понимают и пытаются настраивать приоритеты для входящего. Параметр limit at используется, чтобы гарантировать очереди заданную скорость, если это возможно. При этом он имеет преимущество перед приоритетом. То есть с его помощью можно гарантировать какую-то полосу пропускания трафику с низким приоритетом. Если данный канал не используется полностью, то он доступен другим очередям.

В целом, настройка simple queue в Микротике не представляет какой-то особой сложности и интуитивно понятна. Исключение только параметр Burst. Рассмотрим его отдельно.

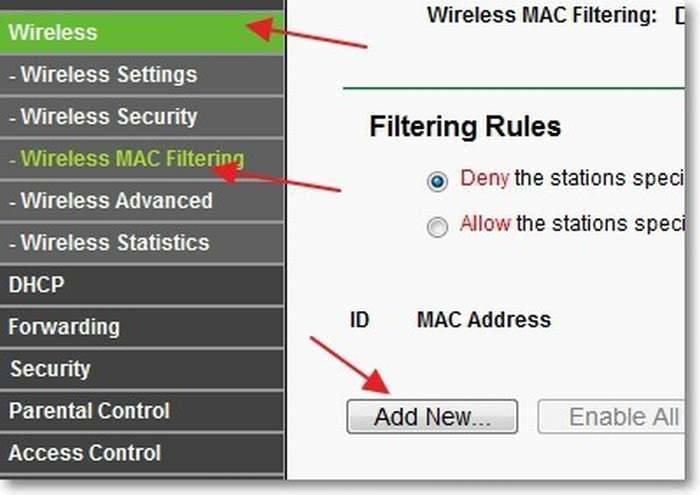

Для случаев, когда MAC может поменяться

Находчивый клиент при наложении ограничений, описанных в предыдущем разделе, может легко изменить физический адрес MAC. Особенно просто это на компьютере. И для подобных ситуаций в прошивке маршрутизатора присутствует решение. Оно заключается в предоставлении доступа к интернету только ограниченному перечню устройств. Остальные, даже те, кто установит подключение, не получат трафика.

Следующая инструкция покажет, как уменьшить скорость интернета:

- Идём во вкладку «Wireless», где заходим в «Wireless MAC Filtering».

- Активируем опцию, перенеся триггерный переключатель в первое положение.

- Кликаем «Add new…» для добавления нового правила.

- Вводим адрес своего компьютера, из которого осуществляете настройку маршрутизатора, а также комментарий и устанавливаем статус «Enable».

- Перезагружаем роутер.

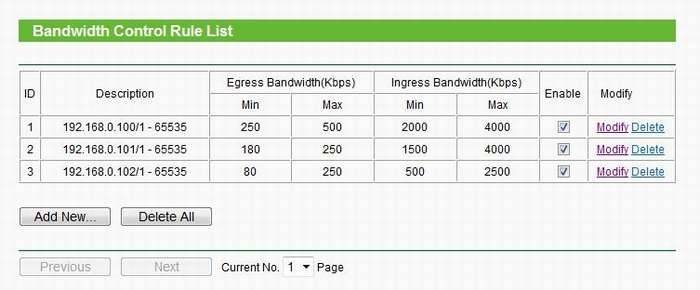

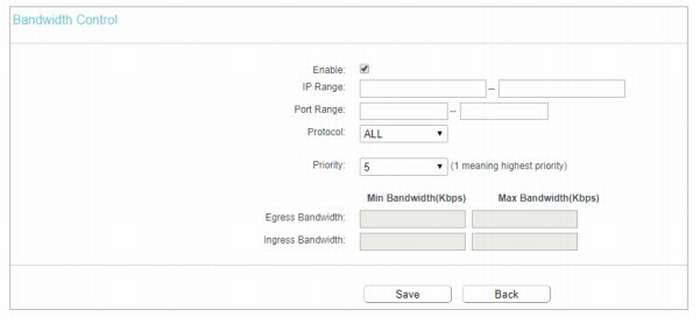

Комбинируя различные способы, можно добиться того, чтобы, например, ограничение по скорости для ваших устройств было меньше (допустим, 5 Мбит/с), а для других пользователей – 3 Мбит/с. Достигается это созданием пары правил.

- Сначала подключаемся к сети со всех своих гаджетов и присваиваем им статичные IP, лучше всего последовательные 192.168.0.1-192.168.0.x.

- Если необходимо, устанавливаем предел скорости приёма и передачи для этих девайсов.

- Для всех остальных устанавливаем автоматическое присваивание IP в указанном диапазоне, куда не входят закреплённые за вашими девайсами адреса.

- Добавляем правило для этого диапазона адресов, чтобы посетители кафе либо соседи не занимали весь канал.

При необходимости условия можно установить для каждого отдельного устройства.

На примере мы присвоили своим ноутбуку, смартфону и планшету IP 192.168.0.100 – 102, поставили им различные лимиты в обоих направлениях и активировали правила.

Для маршрутизаторов с новой прошивкой дизайн программы будет немного отличаться.

Маршрутизаторы TP-Link позволяют регулировать ширину пропускного канала интернета для любых устройств. Для этого в прошивку встроен ряд опций для упрощения решения задачи в различных ситуациях.

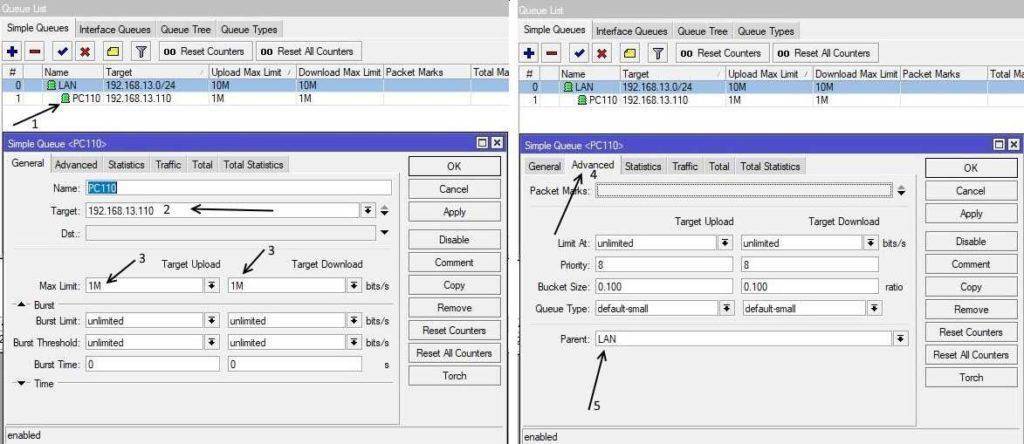

Ограничение скорости по ip компьютера

Если нам надо некоторым компьютерам в рамках очереди LAN ограничить скорость еще, например компьютеру по ip 192.168.13.110 разрешить использовать только 1Mb\s но не ограничивая других. Для этого создаем еще одну очередь с этим ip адресом и указываем родителя очередь LAN, как показано на скриншоте ниже.

Так, например можно резать трафик «качкам» любящим покачать фильмы на работе, отлавливать их с помощью torch и под них создавать очередь.

В общем то данного функционала уже хватить для настройки ограничения скорости в mikrotik cloud core route как и в других роутерах на базе RouterOS.

В следующих статьях попробую подробно описать про типы очередей, queue Tree и так это все работает в связке.

Как включить QoS

Существуют сотни различных маршрутизаторов –домашних и офисных, а также сложных устройств операторского класса. Не каждый из них имеет функцию QoS, а если имеет, то ее реализация может отличаться по спектру возможных настроек. Некоторые могут определять только приоритет между устройствами, некоторые – выделять определенные типы трафика (например, видео или голосовую связь), системы DPI способны распознать приложения, не использующие для обмена данными заранее известные заголовки и структуры данных, вносить изменения в поле приоритета проходящих через него пакетов для дальнейшего применения правил QoS.

Невозможно рассказать о нюансах настройки каждого устройства, но можно описать основные шаги, чтобы начать использовать функцию QoS для обеспечения лучшего качества работы с интернетом.